Unser Kunde sagte: „Ich brauche für meinen Kunden eine Methode mit einer guten Präzision und ohne Ausreißer – alles andere interessiert mich nicht.“ Dieser Kunde ist wichtig, hat keine Ahnung und wir wollen ihn zufrieden stellen. Wie machen wir das?“

Zusammenfassung:

Gute Präzision? So klappt´s:

Hervorragende Werte für die Präzision werden bekannterweise durch eine große Anzahl an Werten erreicht; ferner auch, wenn Messpräzision (Streuung der Werte bedingt lediglich durch das Gerät) statt Methodenpräzision ermittelt wird. Noch „krasser“: Keine Injektion aus sechs vials mit je einer Standardlösung, sondern sechs (drei) Wiederholinjektionen aus einem vial.

Sind Ausreißer vorhanden? So sind keine zu befürchten:

Es sollte als Ausreißertest natürlich der Dixon-Test verwendet werden

a) Kleine Anzahl an Werten: Egal wie stark ein Wert abweicht, wird er kaum als Ausreißer zu deklarieren sein

b) Starke Streuung der Werte – keine Probleme

c) Große Anzahl an Werten (mehr als sechs); da der Dixon-Test hier ungeeignet ist, sind auch hier kaum Ausreißer zu „befürchten“

Die Story:

Anfang des Jahres hat manch eine(r) gute Vorsätze für das neue Jahr; einige wollen vielleicht gar „bessere“ Menschen werden. Lasst uns dennoch für einen Moment ein raffiniertes, böses Teufelchen spielen und uns überlegen, wie man einen Unwissenden begeistern kann. Neben legalen, seien einmal ausnahmsweise auch halblegale und moralisch „grenzwertige“ Tricks/Aussagen erlaubt, die jedoch auf den ersten Blick wahrhaftig erscheinen.

Garantiert „gute“ Präzision:

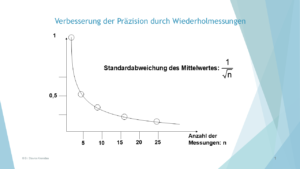

Klassische, legale Vorgehensweise: Viele Werte? Ein kleiner Variationskoeffizient, VK ist mehr als sicher.

Injektion lediglich von Standardlösungen? Da die Geräte heute in der Regel einen hohen technischen Standard aufweisen, ist ein kleiner VK ebenfalls ziemlich leicht zu erreichen.

Test auf Ausreißer – keine Probleme zu befürchten

Ein bekannter Test auf Ausreißer ist der Dixon-Test

Vorgehen: Man bildet die Größe Q nach

Q = | x1 – x2 | / R

x1: ausreißverdächtiger Wert

x2: benachbarter Wert

R : Spannweite (Differenz zwischen kleinstem und größtem

Wert)

Der Ausreißer gilt als erwiesen, wenn der berechnete Wert Q größer ist als ein entsprechender Tabellenwert: Q > Q(P) in der Dixon-Tabelle. Deswegen „Betrag“ in der Formel, weil es um die absolute Differenz zwischen ausreißverdächtigem und benachbartem Wert geht – egal ob sie negativ oder positiv ist.

Die berechnete Größe Q stellt man dem Tabellenwert Q (P) gegenüber:

| ni | P = 0.90 | P = 0.95 | P = 0.99 |

| 3 | 0.89 | 0.94 | 0.99 |

| 4 | 0.68 | 0.77 | 0.89 |

| 5 | 0.56 | 0.64 | 0.76 |

| 6 | 0.48 | 0.56 | 0.70 |

| 7 | 0.43 | 0.51 | 0.64 |

| 8 | 0.40 | 0.48 | 0.58 |

P: Signifikanzniveau, d. h. Wahrscheinlichkeit für die Richtigkeit der getroffenen Aussage

ni: Anzahl der Werte

Es hat sich eingebürgert, dass die Werte der Spalte „P=0.99“ zurate gezogen werden: Ein Wert wäre als Ausreißer zu deklarieren, wenn dieser größer als der entsprechende Wert in der Dixon-Tabelle ist: Dieser Wert ist eben zu 99 % ein Ausreißer. Und bei der relativ kleinen Anzahl an Werten, die wir in der Labor-Welt haben, sollte man für eine bestimmte Aussage schon zu 99 % sicher sein (statistische Relevanz bewahrt!)

Beispiel 1

3 Werte: 4,0 6,0 12,0; der Ausreißer-verdächtige Wert ist definitiv die „12“.

Dixon-Text:

6 – 12 : 8 = 0,75

0,75 ist kleiner als 0,99, also muss die „12“ nicht eliminiert werden

Beispiel 2

7 Werte, die recht stark streuen (kleinster Wert 5, größter Wert 14):

7,0 7,8 5,0 8,3 9,0 6,9 14,0

Ausreißer-verdächtiger Wert ist die „14“

Dixon-Text:

9 – 14: 9 = 0,56

0,56 ist kleiner als 0,64, die „14“ ist „kein“ Ausreißer

Beispiel 3

8 Werte, die nicht so stark streuen:

7,0 7,5 8,0 8,5 7,9 8,9 10,0 14,0

Ausreißer-verdächtigter Wert ist die „14“

Dixon-Text:

10 – 14 : 7 = 0,57

0,57 ist kleiner als 0,58, die „14“ ist „kein“ Ausreißer

Bemerkungen:

- Drei Werte sind zu wenig, um von einer statistischen Relevanz zu sprechen

- Je stärker Werte streuen, um so unwahrscheinlicher wird es, eine starke Abweichung als Ausreißer zu deklarieren

- Je größer die Anzahl der Werte, um so ungeeigneter wird der Dixon-Test; bei diesem Test werden ja nur drei Werte für die Berechnung der Prüfgröße Q berücksichtigt: der Ausreißer-verdächtigte Wert, sein benachbarter Wert und der kleinste Wert. Wie viele Werte dazwischen liegen, ist irrelevant. Deswegen sollte ab ca. sechs Werte der Grubbs-Text verwendet werden (Mittelwert, Standardabweichung für die Berechnung)

Eine analytisch seriös, wahrhaftig klingende Aussage vom Teufelchen könnte in etwa wie folgt lauten:

„Lieber Kunde,

wir haben unsere Methode wirklich sehr gründlich getestet: Die Präzision ist wie du hier siehst, hervorragend. Ferner haben wir die Methode selbstverständlich sowohl für eine kleine Zahl (Beispiel 1) als auch für eine große Anzahl an Werten (Beispiel 3) getestet. Wir haben unsere Methode sogar für die schwierigste Matrix getestet, also nicht nur für Apfelsaft, sondern auch für Spinat (Beispiel 2). Es ergab in keinem einzigen Fall ein Ausreißer, unsere Methode ist somit für dich gut geeignet.“

Jetzt verwandeln wir uns von einem Teufelchen zu einem(r) kritischen Beobachter(in): Wenn Sie Daten erhalten, werfen Sie einen kritischen Blick auf diese sowie auf den verwendeten statistischen Test:

- Anzahl der Werte?

- Sind diese normal/gleichmäßig verteilt?

- Passt der Test zu der Intention, zu den Werten: Wie streng will/muss ich sein (Signifikanzniveau 95 % oder 99 %)?

Präzision:

Wenn Sie das Ergebnis eines Tests zur Präzision mit auffallend vielen Werten bekommen: Handelt es sich um eine Methode mit beispielsweise komplexer Probenaufarbeitung (Extraktion, Derivatisierung)? Oder liegt vielleicht eine komplexe Matrix vor (biologische, Lebensmittel- oder Umweltmatrix)? Dann kann eine große Anzahl an Werten gerechtfertigt sein. Ist das nicht der Fall, liegt womöglich ein unnötiger Fleiß vor, oder … Jedenfalls sollte man schon nach dem Grund fragen.

Ausreißertest:

Bei einer kleinen Anzahl an Werten und/oder starker Streuung ebendieser ist das Fehlen von Ausreißern keinesfalls ein Qualitätsattribut der Methode. Und wenn für ab ca. sechs Werten der Dixon-Text verwendet wird, würde ich der Aussage keinen sonderlichen Wert beimessen.

Meine Erfahrung aus diversen Projekten:

– Nicht-zu-Ende gedachten Vorgaben (Notwendigkeit für diese?),

– starker Focus auf formale Anforderungen zu Lasten analytischer Relevanz und

– mangelndes Wissen um die Aussagekraft von statistisch „sauber“ ermittelten Größen …

… führen des Öfteren dazu, dass die Routineeignung einer Methode zu positiv eingeschätzt wird. Seien Sie kritisch und versuchen Sie praxis-nah zu denken (mir fällt es auch oft schwer).